Quá trình “Crawl” là một khái niệm quan trọng trong lĩnh vực thu thập dữ liệu trên Website. Trên thực tế, quá trình Crawl đóng vai trò quan trọng trong việc xây dựng các công cụ tìm kiếm và cung cấp thông tin đến người dùng. Trong bài viết này, mời bạn đọc cùng Digizone tìm hiểu rõ hơn về quá trình Crawl, cách nó hoạt động và vai trò của nó trên Website.

Crawl là gì?

Crawl là cào dữ liệu (Crawl Data) là một thuật ngữ không còn mới trong Marketing, và SEO. Vì Crawl là kỹ thuật mà các con robots của các công cụ tìm kiếm sử dụng như: Google, Bing Yahoo…

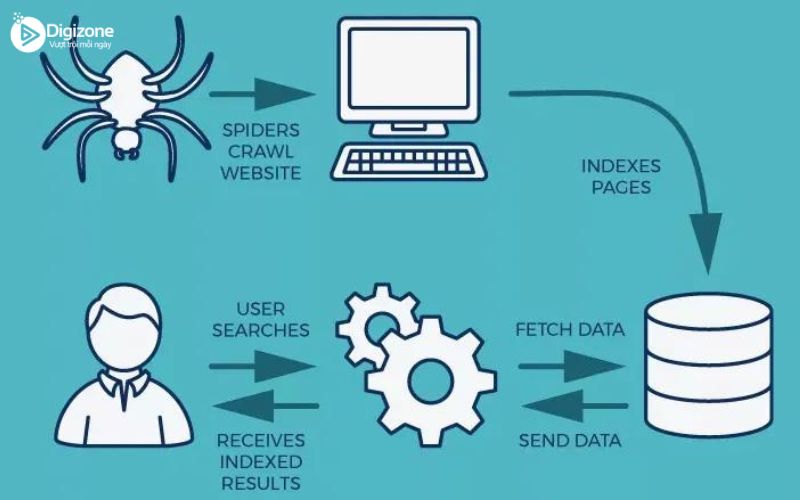

Công việc chính của Crawl là thu thập dữ liệu từ một trang bất kỳ. Rồi tiến hành phân tích mã nguồn HTML để đọc dữ liệu. Và lọc ra theo yêu cầu người dùng hoặc dữ liệu mà Search Engine yêu cầu.

Website Crawl là gì?

Website Crawler (Trình thu thập thông tin Website), Spider hay bot công cụ tìm kiếm có chức năng tải xuống đồng thời Index toàn bộ Content từ khắp mọi nơi trên Internet. Từ “Crawl” trong cụm “Website Crawler” tượng trưng cho một kỹ thuật dùng để chỉ quá trình truy cập Websitesite một cách tự động và lấy data thông qua một chương trình phần mềm.

Mục tiêu của bot là tìm hiểu xem các trang trên Websitesite nói về điều gì. Từ đó, chúng sẽ tiến hành xem xét truy xuất thông tin khi cần thiết. Các bot này hầu hết đều được vận hành bởi các công cụ tìm kiếm.

Bằng phương pháp áp dụng thuật toán tìm kiếm cho dữ liệu thu thập được bởi Website Crawl (data Crawling), công cụ tìm kiếm sẽ có thể cung cấp các liên kết có liên quan mật thiết nhằm đáp ứng các truy vấn tìm kiếm của người dùng. Sau đó, nó sẽ tạo ra danh sách các trang Website cần hiển thị khi người dùng nhập từ khóa vào ô tìm kiếm của Google, Yahoo hoặc Bing,…

>>> Xem thêm: Paid Search là gì? Phân biệt Paid Search và Organic Search

Yếu tố ảnh hưởng đến Crawl

Hiện nay, có rất nhiều yếu tố ảnh hưởng đến tỷ lệ Crawl và index. Dưới đây, là một số yếu tố chính góp vai trò quan trọng trong việc Crawl và index của Google:

- Domain: Khi tên miền có chứa từ khóa chính được đánh giá tốt thì Websitesite Crawler tốt cũng sẽ có được thứ hạng cao trên kết quả tìm kiếm. Trong khi Google Panda được ra đời để đánh giá chất lượng của một domain, thì việc sở hữu một domain chất lượng được quan tâm hơn bao giờ hết.

- Backlink: Các backlink chất lượng đóng vai trò quan trọng góp phần giúp Websitesite thân thiện với công cụ tìm kiếm hơn. Nếu nội dung trên trang của bạn tốt nhưng lại không xuất hiện backlinks nào, thì Google sẽ chỉ định Websitesite của bạn kém chất lượng, không cung cấp nội dung giá trị cho độc giả.

- Internal Link: Internal Link là các liên kết nội bộ trong một Websitesite, là một trong những yếu tố bắt buộc nhất định cần phải có khi làm SEO. Không những thế, nó còn giúp giảm tỷ lệ rời trang Website đồng thời tăng thời gian onsite của người dùng.

- XML Sitemap: Sitemap giúp Google có thể nhanh chóng index hoặc cập nhật bài viết một cách nhanh nhất có thể.

- Duplicate Content: Việc Websitesite trùng lặp nội dung sẽ bị Google block. Chính vì vậy, bạn hãy khắc phục lỗi chuyển hướng 301 và 404 để được Crawling cũng như SEO tốt hơn.

- URL Canonical: Việc tạo đường dẫn URL thân thiện với SEO cho tất cả các trang trên Websitesite sẽ góp phần hỗ trợ tối đa cho Websitesite.

Meta Tags: Việc chèn thêm những meta tags độc đáo sẽ giúp bạn có thể đảm bảo được Websitesite có thứ hạng cao trên kết quả tìm kiếm.

Phân biệt Website Crawl và Website scraping

Website Crawl và Website scraping là hai khái niệm quan trọng trong việc thu thập dữ liệu trên Website, tuy nhiên, chúng có mục đích và phương pháp hoạt động khác nhau. Dưới đây là sự phân biệt giữa Website Crawl và Website scraping:

| Website Crawl | Website Scraping | |

|---|---|---|

| Mục đích | Xây dựng cơ sở dữ liệu và tạo chỉ mục tìm kiếm | Trích xuất dữ liệu cụ thể từ các trang Website |

| Phương pháp | Theo dõi và duyệt qua các liên kết | Sử dụng công cụ hoặc mã tự động để trích xuất dữ liệu |

| Đối tượng | Trang Website và các liên kết trong đó | Các trang Website cụ thể và dữ liệu có cấu trúc |

| Mục tiêu | Thu thập thông tin cơ bản và xây dựng chỉ mục | Trích xuất thông tin cụ thể và có cấu trúc |

| Công cụ | Các công cụ tìm kiếm (ví dụ: Google, Bing) | Các thư viện và công cụ (ví dụ: BeautifulSoup, Scrapy) |

| Dữ liệu thu thập | Thông tin cơ bản (ví dụ: tiêu đề, URL, nội dung văn bản) | Dữ liệu cụ thể và có cấu trúc (ví dụ: tên sản phẩm, giá) |

Vì sao Website Crawl được gọi là “Spiders”?

Thuật ngữ “Spiders” được sử dụng để chỉ Website Crawl bởi vì quá trình này giống như cách một con nhện di chuyển và thu thập thông tin trên Website.

Tương tự như cách một con nhện di chuyển qua các mạng lưới mắc lên trên và thu thập mồi, các chương trình Website Crawl cũng di chuyển qua các trang Website bằng cách theo dõi các liên kết và thu thập thông tin từ mỗi trang mà chúng gặp phải.

Từ “Spiders” hay “Website Spiders” được sử dụng để ám chỉ tính chất của quá trình Website Crawl, trong đó các chương trình tự động điều hướng qua các trang Website giống như cách một con nhện điều hướng qua mạng lưới của nó. Thuật ngữ này mang tính hình tượng và dễ hiểu, giúp mô tả quá trình Crawl một cách hình ảnh và trực quan.

Trên thực tế, World Wide Website chính là nơi xuất phát “www” của phần lớn các URL của trang Website. Việc gọi tên Website Crawlers là “Spiders” là điều hoàn toàn tự nhiên. Bởi lẽ, chúng sẽ có xu hướng thu thập dữ liệu trên mọi trang Website, tương tự như các con nhện bò trên mạng nhện của chúng.

Yếu tố nào ảnh hưởng đến quá trình Crawl?

Có hàng triệu trang Website trên trái đất này. Có phải tất cả mọi người hài lòng với tốc độ Crawl và index không? Câu trả lời là không! Hầu hết mọi người đều không ngừng tự hỏi tại sao bài viết của họ lại không được index.

Hãy cùng xem một số yếu tố chính đóng vai trò quan trọng trong quá trình Crawl và index.

Backlink

Càng có nhiều backlink, trang của bạn càng đáng tin cậy và có uy tín trong mắt các công cụ tìm kiếm. Nếu bạn có thứ hạng tốt nhưng không có được bất kỳ backlink nào cho trang Website, công cụ tìm kiếm có thể cho rằng bạn có nội dung chất lượng thấp.

Liên kết nội bộ

Đã có rất nhiều cuộc thảo luận liên quan đến liên kết nội bộ (còn được gọi là deep link). Mọi người thậm chí còn đề nghị sử dụng cùng một anchor text trong bài viết, vì nó giúp thu thập dữ liệu sâu về một trang Website.

Điều quan trọng cần nhớ là liên kết nội bộ là một điều tốt, không chỉ cho SEO mà còn để duy trì người dùng hoạt động trên trang Website.

Sitemap XML

Thời điểm bạn thiết lập một trang Website trong WordPress, bạn nên sử dụng sitemap XML để sơ đồ trang Website có thể được tạo tự động. Bằng cách này, Google được thông báo rằng trang Website của bạn đã được cập nhật và sẽ muốn thu thập dữ liệu về nó.

Nội dung trùng lặp

Điều này có thể ảnh hưởng xấu đến trang của bạn. Hãy cố gắng không có bất kỳ nội dung trùng lặp trên trang Website.

Tạo URL thân thiện

Hãy tạo URL thân thiện với SEO cho mỗi trang trên Websitesite của bạn. Điều này có ý nghĩa rất lớn đối với quá trình SEO.

Tag meta

Trang Website của bạn nên có tag meta độc nhất và không mang tính cạnh tranh. Điều này sẽ đảm bảo rằng bạn có thứ hạng hàng đầu trong công cụ tìm kiếm.

Ping

Đảm bảo rằng bạn đã thêm tất cả các site ping chính vào trang Websitesite WordPress của mình. WordPress có tính năng tự động ping, sẽ thông báo cho các công cụ tìm kiếm về những cập nhật của trang Website.

Khi bạn tối ưu hóa trang Website của mình dựa trên các yếu tố này, Google sẽ thực hiện quá trình Crawl và index trang nhanh chóng, chính xác hơn.

>>> Xem thêm: DNS là gì? Hướng dẫn sử dụng DNS

Kết luận

Cùng theo dõi Digizone để cập nhật những tin tức hữu ích bạn nhé!